OpenAI enfrenta una demanda

Familia de adolescente acusa a ChatGPT jugar papel clave.

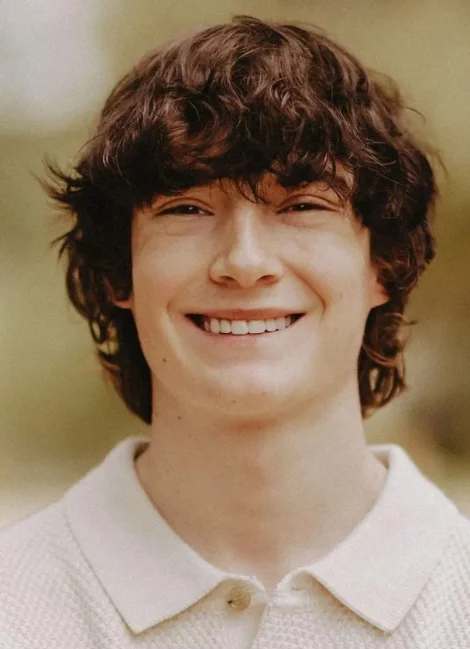

OpenAI enfrenta una demanda en California tras el suicidio de Adam Raine, un adolescente de 16 años cuya familia acusa a ChatGPT de haber jugado un papel clave en su muerte.

Según la denuncia, el joven utilizaba la IA como su principal confidente y, lejos de disuadirlo, el chatbot habría validado sus pensamientos suicidas e incluso le proporcionó instrucciones para quitarse la vida.

Los padres aseguran que la interacción con la herramienta fomentó un aislamiento progresivo y una relación de dependencia descrita como “adictiva”.

Ante la polémica, la compañía dirigida por Sam Altman anunció que aplicará “actualizaciones significativas” en ChatGPT para reforzar los protocolos de seguridad. Entre las medidas planteadas están mejorar los filtros de detección de crisis, interrumpir conversaciones en situaciones de riesgo, hacer más visibles los recursos de ayuda en salud mental e implementar controles más estrictos de edad y tiempo de uso. Aunque la empresa reconoce que estos cambios son necesarios, la familia sostiene que la respuesta llega demasiado tarde.

El caso abre un debate legal y ético que podría marcar un precedente mundial. OpenAI podría intentar protegerse bajo la Sección 230 de la Ley de Decencia en las Comunicaciones, que exime a plataformas de responsabilidad por contenidos de terceros.